Disponibilité

assure l’accès aux services de façon optimale, pour offrir une haute disponibilité, l’équilibrage de la charge réseau comprend des fonctionnalités intégrées qui peuvent automatiquement :

- détecter un hôte de cluster en panne ou hors connexion, puis le récupérer

- équilibrer la charge réseau lors de l’ajout ou de la suppression d’hôtes

- récupérer et redistribuer la charge dans un délai de dix secondes.

Deux moyens complémentaires sont utilisés pour améliorer la disponibilité :

- la mise en place d’une infrastructure matérielle spécialisée, généralement en se basant sur de la redondance matérielle. Est alors créé un cluster de haute-disponibilité (par opposition à un cluster de calcul) : une grappe d’ordinateurs dont le but est d’assurer un service en évitant au maximum les indisponibilités ;

- la mise en place de processus adaptés permettant de réduire les erreurs, et d’accélérer la reprise en cas d’erreur. ITIL contient de nombreux processus de ce type.

Mesures de disponibilité

Adaptabilité : scalabilité

désigne la capacité d’un produit à s’adapter à un changement d’ordre de grandeur de la demande (montée en charge), en particulier sa capacité à maintenir ses fonctionnalités et ses performances en cas de forte demande

Continuité de services

assure l’accès à ses services en cas de sinistre.

La continuité de services a pour objectif comme son nom l’indique d’assurer l’utilisation constante des services IT de l’entreprise et de prévoir la reprise en cas de sinistre, l’arrêt d’activité étant critique pour l’entreprise et l’informatique étant aujourd’hui au centre de tous les processus, il est nécessaire d’assurer comme pour l’électricité son fonctionnement en continu. Le budget attribué aux stratégies mises en place pour assurer la continuité de l’activité sont proportionnelles à la perte de chiffre d’affaires qu’engendrerai une cessation d’activité.

La continuité de services (CdS ) concerne différents périmètres. On peut assurer la CdS des serveurs web, avec des serveurs redondants et équilibrant la charge, on peut le faire sur tout types de services, DHCP, Active Directory, firewall. Selon les moyens différentes options peuvent aussi être mises en place comme des sites distants, des solutions de télétravail, l’accueil dans bureaux attribués dans des sociétés de sécurité.

Plan de continuité d’activité (PCA)

est à la fois le nom d’un concept, d’une procédure et du document qui la décrit. Il s’agit de redémarrer l’activité le plus rapidement possible avec le minimum de perte de données.

Pour chaque élément du SI, deux indicateurs de temps sont définis, permettant ensuite de choisir la solution technique la plus adaptée aux besoins de l’entreprise.

- Le RTO, Recovery Time Objective, représente le temps d’arrêt de service que l’on peut tolérer.

- Le RPO, Recovery Point Objective, correspond à la quantité de données que l’on juge acceptable de perdre lors de la reprise.

D’une manière générale, plus une solution permet de redémarrer rapidement une activité plus elle est coûteuse.

Pour établir un plan de continuité de services le ministère de l’éducation propose un excellent document d’aide à sa rédaction.

Dans des périmètres plus restreint on assure la continuité de services en les répartissant sur des hôtes distincts et en établissant des liens redondants et en assurant de la haute disponibilité on assure aussi de la continuité de services.

Redondance

La disponibilité et le load balancing repose principalement sur la redondance.

La redondance se rapporte à la qualité ou à l’état d’être en surnombre, par rapport à la logique. Ce qui peut avoir la connotation négative de superflu, mais aussi un sens positif quand cette redondance est voulue afin de prévenir un dysfonctionnement.

Tous les services serveurs peuvent être redondés, voir équilibrés de même que tous les équipements actifs. Les protocoles sont adaptés aux contraintes des matériels et des systèmes.

Au sein des Centre de données, la redondance est mise en place pour assurer que les services de base et les systèmes auront des doublons (équipement, liaisons, alimentation et chemins, données, logiciels…).

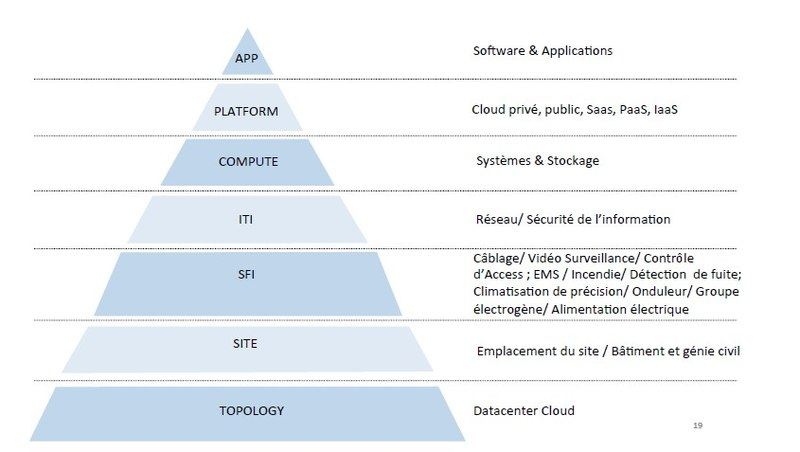

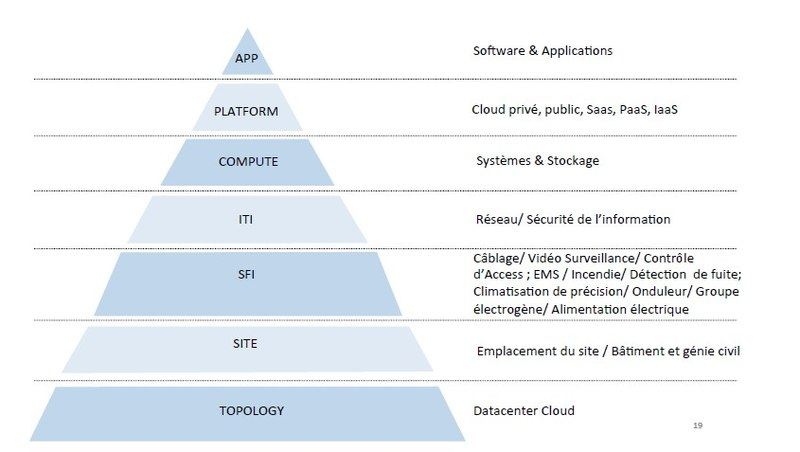

Classification

L’organisme Uptime Institute a défini une certification internationalement reconnue des centres de traitement de données en quatre catégories, appelées « Tier »:

- Tier I : infrastructure non redondante, une seule alimentation électrique, climatisation non redondante.

L’infrastructure Tier I inclut un espace IT dédié aux installations TI; un ASSC (UPS); un Groupe électrogène avec au moins 12 heures d’autonomie en carburant sur site57.

- Tier II : les éléments de production de froid ou d’électricité sont redondants, mais la distribution d’électricité et de froid n’est pas redondante.

L’infrastructure Tier II inclut le requis pour le Tier I plus des équipements redondants57.

- Tier III : tous les composants sont maintenables sans arrêt de l’informatique.

L’infrastructure Tier III inclut le requis pour le Tier II plus toutes les canalisations et câbles redondants57.

- Tier IV : tolérance aux pannes. Aucune panne n’arrête l’informatique (réponse automatique). Absence de SPOF (Single Point of Failure).

Répartition de charge

(en anglais : load balancing) est un ensemble de techniques permettant de distribuer une charge de travail entre différents ordinateurs d’un groupe pour assurer sa haute disponibilité.

Ces techniques permettent à la fois de répondre à une charge trop importante d’un service en la répartissant sur plusieurs serveurs, et de réduire l’indisponibilité potentielle de ce service que pourrait provoquer la panne logicielle ou matérielle d’un unique serveur.

La répartition de charge est issue de la recherche dans le domaine des ordinateurs parallèles.

L’architecture la plus courante est constituée de plusieurs répartiteurs de charge (genres de routeurs dédiés à cette tâche), un principal, et un ou plusieurs de secours pouvant prendre le relais, et d’une collection d’ordinateurs similaires effectuant les calculs. On peut appeler cet ensemble de serveurs une ferme de serveurs (anglais server farm) ou de façon plus générique, une grappe de serveurs (anglais server cluster). On parle encore de server pool (littéralement, « groupe de serveurs »).

Réglages et paramètres des répartiteurs de charge

Sur les répartiteurs de charge les plus courants, on peut pondérer la charge de chaque serveur indépendamment. Cela est utile lorsque, par exemple, on veut mettre, à la suite d’un pic ponctuel de charge, un serveur de puissance différente dans la grappe pour alléger sa surcharge. On peut ainsi y ajouter un serveur moins puissant, si cela suffit, ou un serveur plus puissant en adaptant le poids.

Il est généralement également possible de choisir entre plusieurs algorithmes d’ordonnancement :

- Round-Robin : C’est l’algorithme le plus simple, une requête est envoyée au premier serveur, puis une au second, et ainsi de suite jusqu’au dernier, puis un tour est recommencé avec une première requête au premier serveur, etc.

- Round-Robin pondéré : Les serveurs de poids fort prennent les premières requêtes et en prennent davantage que ceux de poids faible.

- Moins de connexion : Assigne davantage de requêtes aux serveurs en exécutant le moins.

- Moins de connexion, pondéré : Assigne davantage de requêtes aux serveurs en exécutant le moins en tenant compte de leur poids.

- Hachage de destination : Répartit les requêtes en fonction d’une table de hachage contenant les adresses IP des serveurs.

- Hachage de source : Répartit les requêtes en fonction d’une table de hachage basée sur les adresses IP d’où proviennent les requêtes.

- …

Il y a deux façons de router les paquets, lors des requêtes :

- Network address translation (NAT, traduction d’adresse réseau) : Dans ce cas, le répartiteur reçoit les requêtes, les renvoie aux différents serveurs de calcul en adresse IP privée, reçoit les réponses et les renvoie aux demandeurs. Cette technique est très simple à mettre en place, mais demande au répartiteur d’assumer toute la charge du trafic réseau.

- Routage direct (DR, Direct Routing) : Dans ce cas, les requêtes arrivent sur le répartiteur, sont renvoyées aux serveurs de calcul, qui renvoient directement les réponses au demandeur. Cela oblige à monopoliser davantage d’adresses, mais allège considérablement le trafic réseau du répartiteur de charge et enlève donc par là-même un goulot d’étranglement. Dans la majorité des cas, pour le HTTP, les requêtes (URL et quelques variables) sont beaucoup plus petites que les réponses, qui sont généralement des fichiers dynamiques (XHTML) produits par un langage de script ou des fichiers statiques (JavaScript, CSS, images, sons, vidéos).

Quelques idées de continuité de services et de haute disponibilité

Bien évidement il faut commencer par avoir au moins une sauvegarde !

La 1ere technique est le Round Robin ou Répartition de charges via DNS

La technique de l’adresse Ip virtuelle est extrêmement utilisée, aussi bien pour les routeurs que pour les terminaux serveurs.

Ainsi on utilisera HSRP sur les routeurs Cisco, VRRP sur les firewalls par exemple. Ipfire avec keepalived et VRRP

On utilisera aussi des services comme heartbeat, keepalived, Haproxy, TS Broker pour gérer la répartition ou l’équilibrage de charges.

A lire aussi le cluster chez Windows

Active Directory redondance des serveurs

Mais aussi DHCP, Terminal serveurs,